Oracle 19C RAC Veritabanı Kurulumu

- Ekrem Oğuz ŞAHİN

- 13 Ara 2021

- 8 dakikada okunur

Güncelleme tarihi: 11 Ağu 2022

Bu yazımda Oracle Linux 7.9 işletim sistemi üzerine VMware 15.5 ile Oracle High Availability çözümlerinden Real Application Clusters (RAC) kurulumunu anlatacağım. RAC kurulumu için 2 adet sunucuya, her sunucuda iki adet ethernet kartına ve sunucuların ortak olarak görebilecekleri paylaşımlı disklere ihtiyacımız var. Kurulum için gerekli olan dosyaları buradan indirebilirsiniz.

Kurulumumuz 6 aşamadan oluşacak;

• İşletim Sisteminin Kurulması ve Sunucuların Hazır Hale Getirilmesi

• Oracleasm ile disklerin yapılandırılması

• Kurulum Aşamaları I- Grid Kurulumu

• Kurulum Aşamaları II- Oracle Software Kurulumu

• Kurulum Aşamaları III- asmca ile disk group ekleme

• Kurulum Aşamaları IV- DBCA ile veritabanı kurulumu

1- İşletim Sisteminin Kurulması ve Sunucuların Hazır Hale Getirilmesi

İşletim sistemi "Sanal Sunucuya Oracle Linux 7.9 Kurulumu (VMware 15.5)" yazımızda anlatıldığı gibi kurulur.

Ben sunucuyu klonlayarak ilerleyeceğim. Siz dilerseniz kurmuş olduğunuz sunucu üzerinden devam edebilirsiniz.

Kurmuş olduğumuz sunucuya sağ tıklayarak "Manage > Clone" diyerek ilerliyoruz.

"The current state in the virtual machine" diyerek ilerliyoruz.

"Create a full clone" diyerek ilerliyoruz.

Klona bir isim veriyoruz. Ben kurulumda sunucularım için "data4tech01" ve "data4tech02" isimlerini kullanacağım.

"Power on this virtual machine" diyerek sunucumuzu açıyoruz.

Sunucu açıldıktan sonra işletim sistemi güncellemesi yapıyoruz ve kurulum sırasında ihtiyaç duyacağımız paketleri yüklüyoruz.

# yum -y update

# yum install -y oracle-database-preinstall-19c.x86_64

# yum install -y oracleasm-support

# yum install -y dnsmasq*Sunucumuzu klonlamıştık, o yüzden hostname'i klonladığımız sunucu ile aynı. Hostname'i değiştiriyoruz.

# vi /etc/hostname

"Secure Linux" özelliği devre dışı bırakılır.

# vi /etc/selinux/configSELINUX=disabled

"Firewall" durdurulup devre dışı bırakılır.

# systemctl stop firewalld.service

# systemctl disable firewalld.service

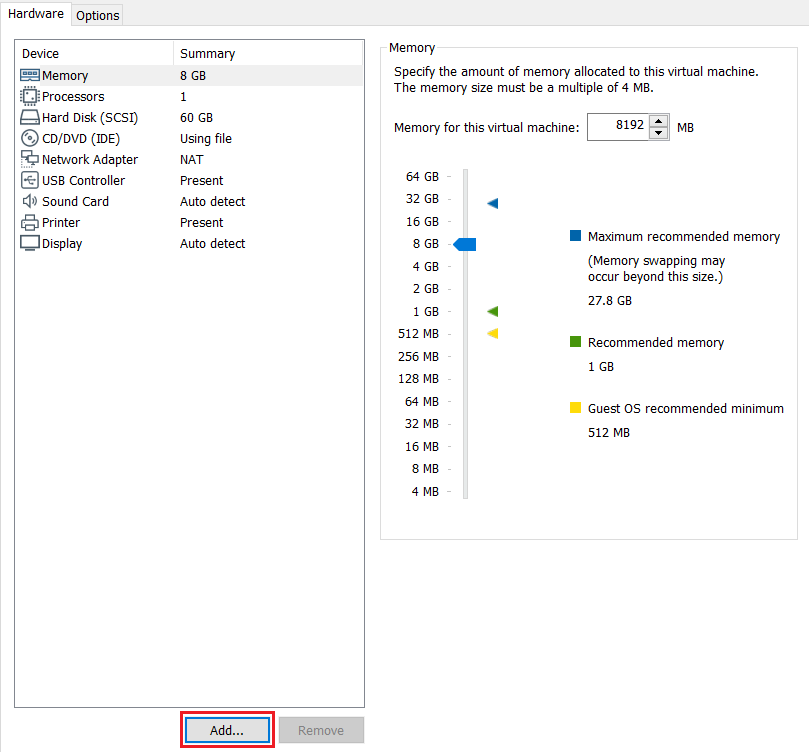

Sunucumuza 2 adet ethernet kartı ekleyeceğiz, bunun için sunucuyu kapatıyoruz.

# shutdown -h now"Edit virtual machine settings" diyoruz.

"Add" diyerek ilerliyoruz.

"Network Adapter" seçiyoruz ve "next" diyoruz.

Aynı şekilde 2 adet ethernet kartı ekliyoruz ve iki kartı da "host-only" olarak ayarlıyoruz.

Sunucuyu açıyoruz.

Ethernet kartları sunucuya "ens37" ve "ens38" olarak eklendiler. Her ikisi için de "connect" diyerek bağlanıyoruz.

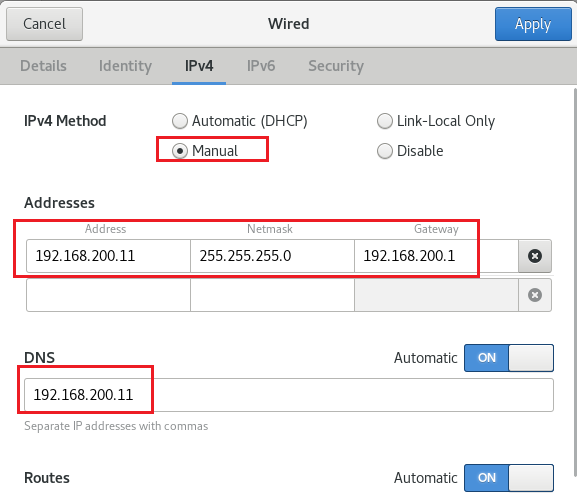

Ens37 için ayarlarımızı yapıyoruz. Bu kartı "public network" için kullanacağız.

Ens38 için ayarlarımızı yapıyoruz. Bu kartı private network için kullanacağız.

Sunucumuzu yeniden başlatıyoruz.

# rebootSunucu açıldıktan sonra /etc/hosts dosyasını düzenliyoruz.

# vi /etc/hosts

Küçük ölçekli bir sistem veya bir test ortamı kuracağımız için isim çözümleme hizmeti için "dnsmasq" kullanacağız. Öncelikle sunucuyu yeniden başlattığımızda otomatik olarak servisin ayağa kalkması için dnsmasq servisini aktif duruma getiriyoruz.

# systemctl enable dnsmasqDaha sonra /etc/dnsmasq.conf dosyasının sonuna aşağıdaki satırı ekliyoruz.

# vi /etc/dnsmasq.conflocal=/localdomain/İsim çözümleme yapacak sunucularda /etc/resolv.conf dosyasına "dnsmasq" yapılandırması yaptığımız sunucumuzun adresini giriyoruz.

Biz dnsmasq yapılandırmasını 1. Node üzerinde yaptığımız için dosyayı şekildeki gibi düzenleyip kilitliyoruz.

# chattr +i /etc/resolv.confSunucuyu yeniden başlatıyoruz.

# rebootScan ip'lerin çözümlenmesini kontrol ediyoruz.

# nslookup data4tech-scan

İlk sunucu için network yapılandırmamız bitti ve ilk sunucumuzu klonlayarak ikinci sunucumuzu oluşturacağız. Daha sonra sunucularımızın ortak olarak göreceği diskleri ekleyeceğiz. Ben bu kısımda sanal makinelerin kurulu olduğu dizinde "ORACLE SHARED FOLDER" adında bir klasör oluşturdum, diskleri burada oluşturacağım. Siz dilediğiniz yerde oluşturabilirsiniz. Oluşturduğum klasörü 1. sunucunun görebileceği şekilde tanıtıyorum.

Next diyerek ilerliyoruz.

Klasörü oluşturduğumuz dizini seçerek ilerliyoruz.

"Enable this share" kutucuğunu işaretleyerek devam ediyoruz.

Klasörü oluşturduk. Bu adımda konfigürasyonlarını yapmış olduğumuz makinemizi en başta yaptığımız gibi klonluyoruz. (Data4tech01' i klonlayacağız. Bu adımları yukarda yaptığımız için bir daha göstermiyorum.)

Klonlama işlemi bittikten sonra sunucumuzu açıyoruz ve hostname'i değiştiriyoruz.

# vi /etc/hostname

Sunucumuzun ip adreslerini düzenliyoruz.

Ens37 için ayarlarımızı yapıyoruz.

Ens38 için ayarlarımızı yapıyoruz.

Sunucumuzu yeniden başlatıyoruz.

# rebootİkinci sunucuyu da isim çözümlemesi yapıyor mu diye kontrol ediyoruz.

# nslookup data4tech-scan

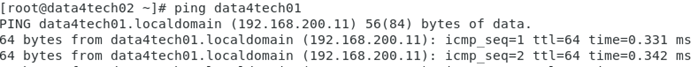

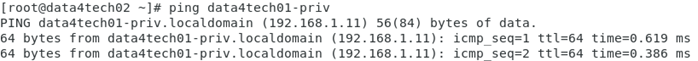

Sunucuların birbirleriyle iletişimlerini kontrol edelim.

1.Sunucuda:

# ping data4tech02

# ping data4tech02-priv

2.Sunucuda:

# ping data4tech01

# ping data4tech01-priv

Daha önce oluşturmuş olduğumuz alana sunucuların ortak olarak görecekleri diskleri ekleyeceğiz. 2 adet disk group oluşturacağım için 2 adet 20 gb disk ekleyeceğiz. Her iki sunucuyu da kapatıyoruz.

# shutdown -h now"Edit virtual machine settings" diyoruz.

"Add" ardından "Hard Disk" diyerek ilerliyoruz.

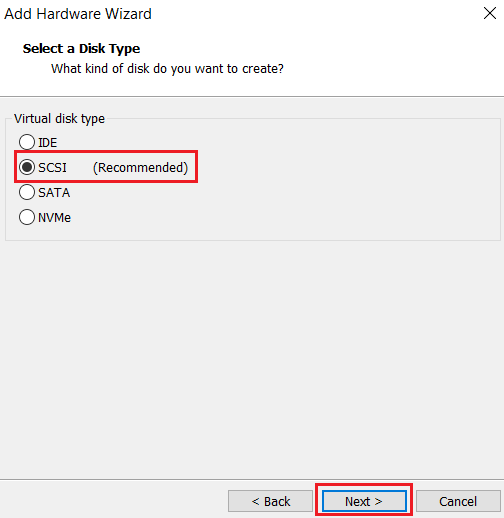

"SCSI" seçerek ilerliyoruz.

Yeni bir sanal disk oluşturarak devam ediyoruz.

"Allocate all disk space now" diyoruz. Next diyerek ilerliyoruz.

İlk diskimi daha önceden oluşturmuş olduğum dosyanın içine “OCR” adı ile oluşturuyorum.

İlk diskimizi oluşturduk, aynı şekilde bu dizine DATA adı ile bir disk daha ekleyelim.

İlk sunucu için diskleri ekledik. Bu diskleri ikinci sunucumuz için de ekliyoruz. "Edit virtual machine settings" diyoruz.

Add dedikten sonra "Hard Disk" seçiyoruz.

"SCSI" seçerek ilerliyoruz.

"Use an existing virtual disk" diyerek ilerliyoruz.

Daha önce eklemiş olduğumuz diski seçiyoruz ve Finish diyerek ilerliyoruz.

Bu işlemleri diğer eklemiş olduğumuz disk için de yapalım.

RAC mantığında her iki sunucunun da diskleri yazabilmesi gerekiyor. Sunuculardan birini açtığımız anda VMware otomatik olarak bu eklediğimiz diskleri kilitleyecek ve diğer sunucunun açılmasını engelleyecek. Bunu önleyebilmek adına sanal sunucuların bulunduğu dizinde bazı düzenlemeler yapmamız gerekiyor.

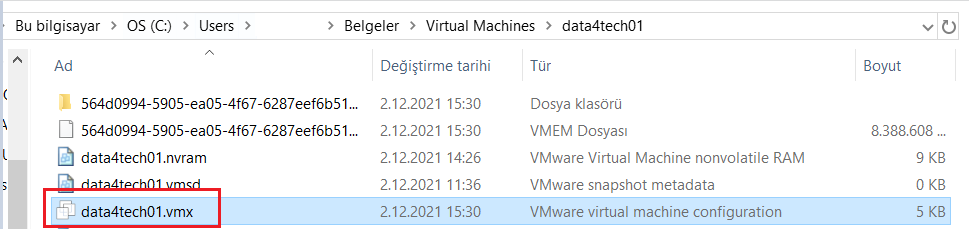

"Data4tech01.vmx" ve "Data4tech02.vmx" adlı dosyaları sanal sunucuların kurulu olduğu dizinde notepad++ ile açıyoruz ve aşağıdaki satırları sona ekliyoruz.

disk.locking = "FALSE"

diskLib.dataCacheMaxSize = "0"

disk.enableuuid = "TRUE"

bios.bootdelay = "8000"

2- Oracleasm ile disklerin yapılandırılması

Eklediğimiz diskleri kontrol edelim.

# ls -al /dev/sd*/dev/sda

/dev/sda1

/dev/sda2

/dev/sdb

/dev/sdc

Burada görünen "sdb" ve "sdc" bizim sonradan eklediğimiz diskler. Bu diskleri "fdisk" komutu ile partitionlayacağız. (Sadece 1. sunucu üzerinde yapıyoruz.)

sdb partitionlanması:

sdc partitionlanması:

Oluşan partitionları "sdb1" ve "sdc1" şeklinde görüyoruz.

# ls /dev/sd*

Oracle ASM Library yapılandırıp disklerimizi ASM için damgalayacağız.

Oracleasm konfigürasyonumuzu yapıyoruz.

Sunucu1:

# oracleasm configure -i Configuring the Oracle ASM library driver. This will configure the on-boot properties of the Oracle ASM library driver. The following questions will determine whether the driver is loaded on boot and what permissions it will have. The current values will be shown in brackets (‘[]’). Hitting <ENTER> without typing an answer will keep that current value. Ctrl-C will abort. Default user to own the driver interface []: oracle Default group to own the driver interface []: oinstall Start Oracle ASM library driver on boot (y/n) [n]: y Scan for Oracle ASM disks on boot (y/n) [y]: y Writing Oracle ASM library driver configuration: done

Parametreleri kontrol edebiliriz.

# oracleasm configure

# oracleasm initCreating /dev/oracleasm mount point: /dev/oracleasm Loading module “oracleasm”: oracleasm Configuring “oracleasm” to use device physical block size Mounting ASMlib driver filesystem: /dev/oracleasm

# oracleasm createdisk OCR /dev/sdb1Writing disk header: done

Instantiating disk: done

# oracleasm createdisk DATA /dev/sdc1Writing disk header: done

Instantiating disk: done

# oracleasm scandisks

# oracleasm listdisks

Sunucu2:

# oracleasm configure -i Configuring the Oracle ASM library driver. This will configure the on-boot properties of the Oracle ASM library driver. The following questions will determine whether the driver is loaded on boot and what permissions it will have. The current values will be shown in brackets (‘[]’). Hitting <ENTER> without typing an answer will keep that current value. Ctrl-C will abort. Default user to own the driver interface []: oracle Default group to own the driver interface []: oinstall Start Oracle ASM library driver on boot (y/n) [n]: y Scan for Oracle ASM disks on boot (y/n) [y]: y Writing Oracle ASM library driver configuration: done

# oracleasm initCreating /dev/oracleasm mount point: /dev/oracleasm Loading module “oracleasm”: oracleasm Configuring “oracleasm” to use device physical block size Mounting ASMlib driver filesystem: /dev/oracleasm

# oracleasm scandisks

# oracleasm listdisks

3- Kurulum Aşamaları I- Grid Kurulumu

Her iki sunucumuzda da dosya dizinlerimizi oluşturuyoruz. Ben kurulumda gerekli olan dosyaları atmak için "/u01/oraInstall" adlı bir dizin oluşturuyorum. Dilerseniz kurulum dosyalarınızı farklı yere atabilirsiniz.

# mkdir -p /u01/app/19/grid

# mkdir -p /u01/app/oracle/product/19/db_1

# mkdir -p /u01/oraInstall

# chown -R oracle:oinstall /u01

# chmod -R 775 /u01Oracle kullanıcısının şifresini değiştiriyoruz. (Her iki sunucuda da)

# passwd oracleOracle kullanıcısına geçerek profil dosyalarımızı oluşturuyoruz.

Sunucu1:

# su - oracle

$ vi .profile_crs

$ vi .profile_db[oracle@data4tech01 ~]$ cat .profile_crs ORACLE_SID=+ASM1; export ORACLE_SID

GRID_HOME=/u01/app/19/grid; export GRID_HOME

ORACLE_HOME=$GRID_HOME; export ORACLE_HOME

PATH=$ORACLE_HOME/bin:$PATH:$HOME/bin:/usr/sbin; export PATH

LD_LIBRARY_PATH=$ORACLE_HOME/lib:/lib:/usr/lib; export LD_LIBRARY_PATH

CLASSPATH=$ORACLE_HOME/JRE:$ORACLE_HOME/jlib:$ORACLE_HOME/rdbms/jlib; export CLASSPATHexport CLASSPATH=$ORACLE_HOME/JRE:$ORACLE_HOME/jlib:$ORACLE_HOME/rdbms/jlib

[oracle@data4tech01 ~]$ cat .profile_dbORACLE_HOSTNAME=data4tech01.localdomain; export ORACLE_HOSTNAME

ORACLE_SID=orcl1; export ORACLE_SID

ORACLE_UNQNAME=orcl; export ORACLE_UNQNAME

ORACLE_BASE=/u01/app/oracle; export ORACLE_BASE

ORACLE_HOME=/u01/app/oracle/product/19/db_1; export ORACLE_HOME

ORACLE_TERM=xterm; export ORACLE_TERM

TMP=/tmp; export TMP

TMPDIR=$TMP; export TMPDIR

PATH=$ORACLE_HOME/bin:$PATH:$HOME/bin:/usr/sbin; export PATH

LD_LIBRARY_PATH=$ORACLE_HOME/lib:/lib:/usr/lib; export LD_LIBRARY_PATH

CLASSPATH=$ORACLE_HOME/JRE:$ORACLE_HOME/jlib:$ORACLE_HOME/rdbms/jlib; export CLASSPATH

Sunucu2:

# su - oracle

$ vi .profile_crs

$ vi .profile_db[oracle@data4tech02 ~]$ cat .profile_crsORACLE_SID=+ASM2; export ORACLE_SID

GRID_HOME=/u01/app/19/grid; export GRID_HOME

ORACLE_HOME=$GRID_HOME; export ORACLE_HOME

PATH=$ORACLE_HOME/bin:$PATH:$HOME/bin:/usr/sbin; export PATH

LD_LIBRARY_PATH=$ORACLE_HOME/lib:/lib:/usr/lib; export LD_LIBRARY_PATH

CLASSPATH=$ORACLE_HOME/JRE:$ORACLE_HOME/jlib:$ORACLE_HOME/rdbms/jlib; export CLASSPATHexport CLASSPATH=$ORACLE_HOME/JRE:$ORACLE_HOME/jlib:$ORACLE_HOME/rdbms/jlib

[oracle@data4tech02 ~]$ cat .profile_dbORACLE_HOSTNAME=data4tech02.localdomain; export ORACLE_HOSTNAME

ORACLE_SID=orcl2; export ORACLE_SID

ORACLE_UNQNAME=orcl; export ORACLE_UNQNAME

ORACLE_BASE=/u01/app/oracle; export ORACLE_BASE

ORACLE_HOME=/u01/app/oracle/product/19/db_1; export ORACLE_HOME

ORACLE_TERM=xterm; export ORACLE_TERM

TMP=/tmp; export TMP

TMPDIR=$TMP; export TMPDIR

PATH=$ORACLE_HOME/bin:$PATH:$HOME/bin:/usr/sbin; export PATH

LD_LIBRARY_PATH=$ORACLE_HOME/lib:/lib:/usr/lib; export LD_LIBRARY_PATH

CLASSPATH=$ORACLE_HOME/JRE:$ORACLE_HOME/jlib:$ORACLE_HOME/rdbms/jlib; export CLASSPATH

Profilleri ayarladıktan sonra her iki sunucuda da chrony servisini başlatıyoruz.

# systemctl enable chronyd

# systemctl restart chronydİndirmiş olduğumuz kurulum dosyalarını 1. Sunucuda /u01/oraInstall altına atıyoruz.

# chown oracle.oinstall /u01/oraInstall/LINUX*

# chmod 777 /u01/oraInstall/LINUX*

Oracle kullanıcısı ile zip açılır.

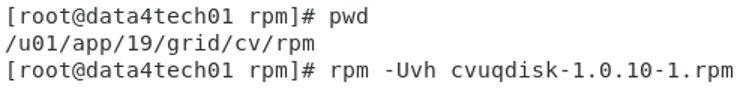

$ unzip LINUX.X64_193000_grid_home.zip -d /u01/app/19/grid/Root kullanıcısı ile cvuqdisk kurulur. (Her iki sunucuda da)

# rpm -Uvh cvuqdisk-1.0.10-1.rpm

Zip'i ilk sunucuda açtığımız için cvuqdisk rpm'i ikinci sunucuda yok, bu yüzden scp ile gönderip kuruyoruz.

# scp cvuqdisk-1.0.10-1.rpm root@data4tech02:/tmp

2. Sunucuda /tmp dizini altına gidip kuruyoruz.

# cd /tmp

# rpm -Uvh cvuqdisk-1.0.10-1.rpm1.Sunucu da kuruluma başlıyoruz. Başlamadan önce bi reboot atalım. Giriş yaparken oracle kullanıcısı ile giriş yapın.

$ cd /u01/app/19/grid

$ ./gridSetup.sh"Configure Oracle Grid Infastructure for a New Cluster" diyerek kuruluma başlıyoruz.

"Configure an Oracle Standalone Cluster" diyerek devam ediyoruz.

Cluster ve Scan isimlerimizi ayarlıyoruz. Cluster Name'i 15 karakterden uzun girerseniz kurulum esnasında hata alırsınız. (Root.sh 16. Adım)

İkinci sunucumuzun bilgilerini ekliyoruz.

Ssh connectivity test ediyoruz, eğer bağlantı yoksa setup diyerek kuruyoruz.

Eğer sunucular arasında ssh connectivity yoksa oracle kullanıcısının şifresini girerek arayüzün bağlantı oluşturmasını sağlayabilirsiniz.

Ağ yapılandırmamızı tanımlıyoruz. Ens37 için public ve Ens38 için private kullanacağımızı belirtmiştik.

"Use Oracle Flex ASM for storage" diyerek devam ediyoruz.

"No" diyerek devam ediyoruz.

Change Discovery Path ile disklerimizi tanımladığımız dizin seçilir. Disk Group Name OCR olarak ayarlanır. Redundancy ise External seçilir.

High Redundancy: Veriler 3 farklı kopya halinde tutulur. 2 fail grup çökse dahi veri kaybı yaşanmaz.

Normal Redundancy: Veriler 2 farklı kopya halinde tutulur. Diğer fail grup çökse dahi veri kaybı yaşanmaz.

External Redundancy: Veriler tek kopya halinde tutulur. Sistemleri en azından normal redundancy disk grouplarda tutmakta fayda var.

Şifreleri ayarlıyoruz. Farklı şifreler verebilirsiniz, ben aynı şifreyi vereceğim.

"Do not use Intelligent Platform Management Interface (IPMI)" seçerek ilerliyoruz.

EM Cloud Control kullanmayacağımız için next diyerek ilerliyoruz.

Grupları ayarlayarak devam ediyoruz.

Oracle Base dizinimizin doğru olup olmadığını teyit ederek devam ediyoruz.

Next diyerek ilerliyoruz.

Scriptleri manuel olarak çalıştırmanızı öneririm fakat burada test ortamı olduğu için otomatik çalıştıracağız.

Prechecklerde bir sıkıntı yok NTP ignore edilebilir. Swap size sunucuyu kurarken 4 gb verdiğimiz için hata verdi, 8 olmalıydı. Next diyerek kuruluma geçiyoruz.

Swap size artırmak için Linux İşletim Sisteminde Swap Alanı Artırma yazımıza bakabilirsiniz.

"Install" diyerek kuruluma başlıyoruz.

Scriptleri otomatik olarak çalıştırabilmek için izin istiyor. Yes diyerek izin veriyoruz.

!!! Kurulum bitişinde karşınıza "PRVG-13606" hatası çıkabilir bu NTP ile ilgili bir hata yok sayabilirsiniz.

Grid kurulumumuz böylece bitmiş oldu.

Oracle kullanıcısı ile oluşturduğumuz .profile_crs' i set ediyoruz.

$ . .profile_crs

$ crsctl stat res -t--------------------------------------------------------------------------------

Name Target State Server State details

--------------------------------------------------------------------------------

Local Resources

--------------------------------------------------------------------------------

ora.LISTENER.lsnr

ONLINE ONLINE data4tech01 STABLE

ONLINE ONLINE data4tech02 STABLE

ora.chad

ONLINE ONLINE data4tech01 STABLE

ONLINE ONLINE data4tech02 STABLE

ora.net1.network

ONLINE ONLINE data4tech01 STABLE

ONLINE ONLINE data4tech02 STABLE

ora.ons

ONLINE ONLINE data4tech01 STABLE

ONLINE ONLINE data4tech02 STABLE

--------------------------------------------------------------------------------

Cluster Resources

--------------------------------------------------------------------------------

ora.ASMNET1LSNR_ASM.lsnr(ora.asmgroup)

1 ONLINE ONLINE data4tech01 STABLE

2 ONLINE ONLINE data4tech02 STABLE

3 ONLINE OFFLINE STABLE

ora.LISTENER_SCAN1.lsnr

1 ONLINE ONLINE data4tech01 STABLE

ora.LISTENER_SCAN2.lsnr

1 ONLINE ONLINE data4tech02 STABLE

ora.LISTENER_SCAN3.lsnr

1 ONLINE ONLINE data4tech02 STABLE

ora.OCR.dg(ora.asmgroup)

1 OFFLINE OFFLINE STABLE

2 ONLINE ONLINE data4tech02 STABLE

3 OFFLINE OFFLINE STABLE

ora.asm(ora.asmgroup)

1 ONLINE OFFLINE data4tech01 Instance Shutdown,STARTING

2 ONLINE ONLINE data4tech02 Started,STABLE

3 OFFLINE OFFLINE STABLE

ora.asmnet1.asmnetwork(ora.asmgroup)

1 ONLINE ONLINE data4tech01 STABLE

2 ONLINE ONLINE data4tech02 STABLE

3 OFFLINE OFFLINE STABLE

ora.cvu

1 ONLINE ONLINE data4tech02 STABLE

ora.data4tech01.vip

1 ONLINE ONLINE data4tech01 STABLE

ora.data4tech02.vip

1 ONLINE ONLINE data4tech02 STABLE

ora.qosmserver

1 ONLINE ONLINE data4tech02 STABLE

ora.scan1.vip

1 ONLINE ONLINE data4tech01 STABLE

ora.scan2.vip

1 ONLINE ONLINE data4tech02 STABLE

ora.scan3.vip

1 ONLINE ONLINE data4tech02 STABLE

4- Kurulum Aşamaları II- Oracle Software Kurulumu

Oracle kullanıcısı ile zipi açıyoruz.

$ unzip LINUX.X64_193000_db_home.zip -d /u01/app/oracle/product/19/db_1Kurulumu başlatıyoruz.

$ cd /u01/app/oracle/product/19/db_1

$ ./runInstaller"Software only" diyerek ilerliyoruz.

"Oracle Real Application Clusters database installation" diyerek devam ediyoruz.

İki sunucunun da seçili olduğuna emin olup next diyoruz.

Enterprise Edition seçerek ilerliyoruz.

Software location’ın "/u01/app/oracle/product/19/db_1" dizini olduğundan emin olup ilerliyoruz.

Next diyerek ilerliyoruz.

Otomatik olarak scriptleri çalıştırması için root şifresini veriyoruz.

NTP’i yine ignore all diyerek geçebiliriz.

Install diyerek ilerliyoruz.

Scriptleri otomatik olarak çalıştırması için onaylıyoruz.

Close diyerek software kurulumunu tamamlıyoruz.

4- Kurulum Aşamaları III- asmca ile disk group ekleme

Veritabanını kuracağımız disk grubunu asmca toolu ile oluşturacağız.

Öncelikle oracle kullanıcısı ile .profile_crs set ediyoruz.

$ . .profile_crs

$ asmcaGörüldüğü gibi 1 adet disk grubumuz var bunu grid kurulumu esnasında oluşturmuştuk.

"Disk Groups" sekmesine sağ tıklayarak "create" diyoruz.

Veritabanını kuracağımız disk group’a DATA adını veriyorum. Siz kendi isteğinize göre isimlendirebilirsiniz. Daha önce oracleasm ile biçimlendirmiş olduğumuz diski ekliyoruz. OK basıyoruz.

Disk grubumuz oluşturulduk. Disk grouplarımızı şekildeki gibi görüntüleyebiliriz. Exit diyerek asmca tool’undan çıkıyoruz.

5- Kurulum Aşamaları IV- DBCA ile Veritabanı Kurulumu

Öncelikle oracle kullanıcısı ile .profile_db set ediyoruz.

$ . .profile_db

$ dbca"Create a database" diyoruz.

"Advanced Configuration" diyerek devam ediyoruz.

"General Purpose or Transaction Processing" seçerek Next diyoruz.

Sunucuların seçili olduğundan emin olup next diyoruz.

Bu ekranda veritabanımızın adı ve sid değeri verilmesi gerekiyor. Biz ikisini de 'orcl' olarak veriyoruz. "Create as Container database" seçeneğini işaretlemeden devam ediyoruz.

Eklemiş olduğumuz diskgroup olan +DATA’ yı seçiyoruz.

Arşiv modunu açmıyorum. Bu konuya ileride değineceğiz.

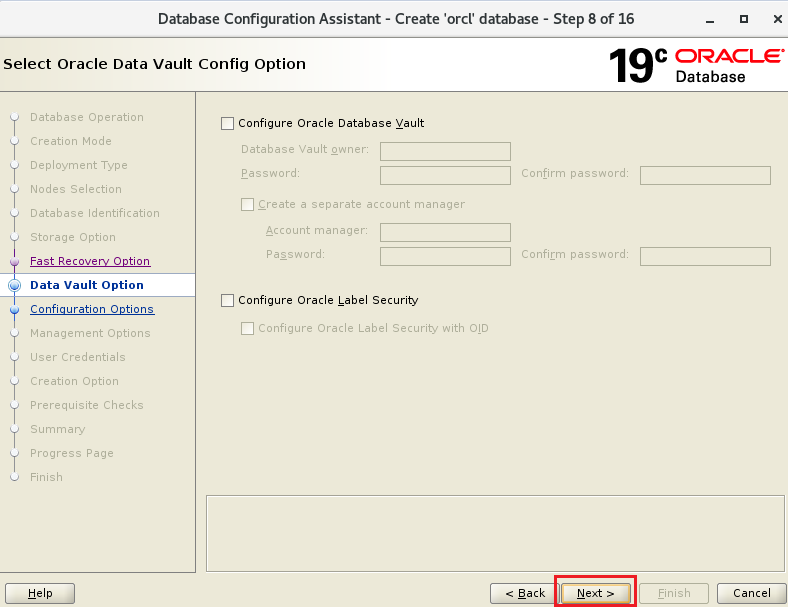

DB Vault ve Label Security kullanmayacağımız için next diyoruz.

ASSM kullanarak devam ediyoruz, isterseniz sisteminize uygun olarak özelleştirebilirsiniz. Burada önemli olan sunucumuzun fiziksel RAM değerinin 3'te 2'sini geçmeyecek şekilde bu değeri belirlemektir.

Karakter setimizi seçiyoruz.

"Dedicated server mode" seçerek ilerliyoruz.

İsteğe göre "HR" şemasını etkinleştirebilirsiniz. Next diyerek ilerliyoruz.

Cloud control kullanmayacağımız için ilerliyoruz.

SYS ve SYSTEM için şifreleri belirliyoruz.

Create Database seçeneğini seçip ilerliyoruz.

Swap size’ı ignore edip devam ediyoruz.

Finish diyerek kuruluma başlıyoruz.

Close diyerek kurulumu bitiriyoruz.

Böylece "Oracle 19C RAC Veritabanı Kurulumu" yazımın sonuna gelmiş bulunuyorum.

Gelecek yazılarımızda görüşmek üzere, sağlıcakla kalın...

Comentários